Предел по нагреву для серверного оборудования следующего поколения(10.08.2013)

Многие эксперты согласны с тем, что повышение температуры воздуха, который нагнетается в сервер – как рекомендуют составители стандарта ASHRAE TC9.9 “Руководящие принципы по терморегулированию” – действительно позволяет сэкономить много электроэнергии, идущей на запитку системы охлаждения центра обработки данных. Документ ASHRAE TC9.9 был опубликован еще в 2011 году Американским обществом инженеров по отоплению, охлаждению и кондиционированию воздуха (American Society of Heating, Refrigerating and Air conditioning Engineers; ASHRAE). Тем не менее, отнюдь не все операторы ЦОД восприняли приведенные в документе рекомендации с должным вниманием.

Практика показывает, что чем выше температура подводимого к серверу воздуха, тем большее количество часов в год система охлаждения дата-центра может проработать в режиме фрикулинга (с отключенными компрессорами) – как и описано в стандарте ASHRAE. Кроме того, подобный подход позволяет добиться существенного снижения так называемого “частичного коэффициента PUE” (partial Power Usage Effectiveness; partial PUE; pPUE), который находит все более широкое применение в индустрии ЦОД. Согласно нормам разработанной консорциумом The Green Grid методики, коэффициент PUE определяется для отдельных модулей дата-центра и отдельных машзалов с серверным и сетевым оборудованием.

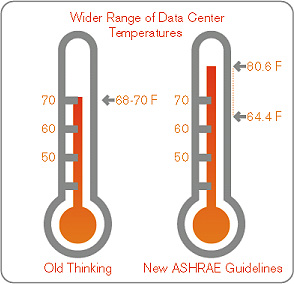

Составители стандарта ASHRAE TC9.9 выделили четыре класса аппаратного обеспечения для дата-центров: A1, A2, A3 и A4. Максимальный интерес для большинства операторов ЦОД представляют аппаратные платформы из класса A1 (корпоративные серверы и системы хранения данных), которые и используются во многих дата-центрах. Эксперты ASHRAE рекомендовали при работе с оборудованием всех классов придерживаться следующих ограничений: температура нагнетаемого в сервер воздуха должна составлять от 18°C до 27°C, а относительная влажность должна быть равна 60% при температуре точки росы от 5.5°C TP (DP) до 15°C TP (DP).

То есть специалисты организации по стандартизации фактически рекомендовали поднять температуру подводимого к оборудованию воздуха для минимизации операционных расходов. Однако эта и ряд других в общем-то, простых и логичных рекомендаций пока еще не получили должного внимания ввиду консервативности многих операторов ЦОД, обуславливающей их нежелание отходить от проверенных временем подходов к организации функционирования серверного оборудования.

Наибольшее внимание IT-специалистов досталось лимитам по температуре и влажности, установленным в стандарте ASHRAE TC9.9 для IT-оборудования класса A4 (от 5°C до 45°C при температуре точки росы в 12°C TP (DP) и относительной влажности от 8% до 90%).

Следует отметить, что купить то самое оборудование класса A4 очень трудно ввиду относительно невысокой распространенности и дороговизны (не говоря уже о том, что многие операторы ЦОД обходят эти продукты стороной из-за своего консерватизма). Тем не менее, большинство экспертов сходится во мнении, что именно за аппаратными платформами A4 “будущее” индустрии ЦОД.

В настоящее время многие проектировщики ЦОД и производители серверного оборудования продолжают осторожничать и используют лимиты, введенные в 2008 году (при этом “параноики” применяют еще более строгие рекомендации 2004 гада). Но есть один интересный момент, который часто упускается из виду знакомящимися с текстом стандарта ASHRAE TC9.9 в редакции от 2011 года специалистами: изложенные в документе рекомендации подходят даже для устаревшего оборудования, а не только для новеньких серверов. Следовательно, стремление некоторых операторов ЦОД оправдать устаревшим оборудованием свой консерватизм и нежелание повышать температуру нагнетаемого в серверы воздуха, является безосновательным.

Противники подвода к IT-оборудованию воздуха с температурой в 45°C отмечают, что температура на выходе в «горячей» коридор в таком случае будет приближаться к 65°С, что самым негативным образом скажется на состоянии проходящих в непосредственной близости от коридора силовых кабелей или оптоволокна, не говоря уже о бедных IT-специалистах, которым в силу специфики работы иногда приходится ходить по «горячему» коридору, чтобы взаимодействовать с серверами. Иными словами, вскоре «холодный» коридор вполне может стать «горячим». При этом тот коридор, который мы сейчас называем «горячим», будет переименован в «очень горячий».

В связи с возможными изменениями большой интерес представляют планы на будущее, которые разрабатываются лидирующими на рынке серверных продуктов для дата-центра OEM-производителями. Ниже приводится информация, предоставленная одной из таких компаний, название которой мы упоминать не будем по просьбе ее представителей.

Следующее поколение серверного оборудования (в случае рассматриваемого вендора уже 13-е по счету) будет «способно» эффективно работать при температуре до 45°С, но «оптимизированы» эти машины будут для работы при температуре в 27°C. Это хорошая новость, так как рекомендации самого вендора могут развязать руки некоторым операторам ЦОД, которые давно хотели поэкспериментировать с температурным режимом. Кроме того, подобная опция позволит минимизировать ущерб в случае краткосрочного отказа системы охлаждения, а в некоторых регионах – перейти на 100-процентный фрикулинг.

Тем не менее, в настоящее время наибольший интерес представляет именно подведение к серверам воздуха с температурой в 27°C. Исследования показывают, что именно при таком тепловом режиме сохраняют эффективность вентиляторы, используемые для теплового контроля всех компонентов вычислительной системы. Специалисты ресурса Datacenter Dynamics, выяснили, что при 27°С вентиляторы в типичном 300-ваттном сервере (современного образца) потребляют всего около 20 Вт. При 45°С энергопотребление блока вентиляторов увеличивается до 200 Вт, что довело общую мощность системы до 500 Вт (67-процентное увеличение нагрузки на ИБП и электроэнергетическую инфраструктуру). Но растет не только энергопотребление вентиляторов, но и уровень шумового загрязнения.

Тесты с применением современного серверного оборудования показали, что нельзя добиться сколь-либо значимой экономии электроэнергии, подводя к серверу очень горячий воздух (с температурой выше, чем 30-35°C), и минимизировать расходы на систему охлаждения. Следовательно, для эффективного применения вышеописанного механизма минимизации операционных расходов за счет снижения энергопотребления системы охлаждения ЦОД необходимо коренным образом менять конструкцию самих серверов.

Не будем также забывать и о том, что температура «горячего» коридора в таких случаях может приближаться к 50°C. К счастью, планы на будущее многих вендоров связаны с перемещением всех коннекторов и соединений с монтажной стороны сервера на фронтальную — туда, где подключаемое оборудование и люди могут работать с должным комфортом. То есть монтажная (задняя) сторона серверной стойки и «горячий» коридор вскоре перестанут нуждаться в периодическом обслуживании, и доступ к ним будет осуществляться лишь в экстренных случаях.

Если все производители будут работать в означенном выше направлении, у нас появится возможность эксплуатировать оборудование в мультивендорном ЦОД при температуре подводимого к серверам воздуха до 27°С, а также периодически повышать порог до 45°C, чтобы максимизировать полезный эффект от фрикулинга в зависимости от конкретных внешних климатических условий. Очень привлекательная перспектива.

Очевидно, что есть некоторые регионы, где применение системы фрикулинга на основе подобной концепции все еще будет не очень эффективным – постоянно высокий уровень влажности исключает какие-либо преимущества, заставляя операторов ЦОД удерживать температуру серверов ниже 23°C.

Правила использования материалов сайта

|